🚀 Mientras lanzamos Foxize MyTutor, nuestro LMS también evoluciona

ChatGPT y bienestar emocional: Lo que revela el primer estudio exhaustivo de OpenAI y MIT

Ética y privacidad en la implementación de Foxize MyTutor con IA generativa

En la era de la inteligencia artificial generativa, la formación personalizada se ha convertido en una potente herramienta para impulsar el desarrollo profesional. Sin embargo, con grandes avances vienen también grandes responsabilidades éticas.

La implementación de soluciones como Foxize MyTutor debe ir acompañada de un firme compromiso con la ética y la privacidad.

Más allá del cumplimiento legal

Cumplir con el RGPD o con las normativas de protección de datos es solo el punto de partida. En Foxize, entendemos que tratar datos personales para personalizar la formación requiere una transparencia proactiva: explicar cómo se usan los datos, qué tipo de personalización se aplica y cómo se protege la información del usuario.

El marco normativo europeo establece unos mínimos exigentes, pero las empresas verdaderamente comprometidas con la ética digital deben ir más allá. Según un estudio del Instituto de Ética en IA de Oxford, las organizaciones que adoptan enfoques proactivos en privacidad generan un 23% más de confianza entre sus usuarios que aquellas que simplemente cumplen con los requisitos mínimos.

La transparencia algorítmica es otro aspecto fundamental. Los participantes en programas formativos tienen derecho a entender cómo la IA toma decisiones sobre su aprendizaje, qué factores considera y cómo estos influyen en las recomendaciones de contenido personalizado, como señala la Comisión Europea.

Trazabilidad, no vigilancia

Una de las claves éticas en el uso de IA generativa es evitar que el seguimiento del progreso formativo se convierta en una forma de vigilancia. Foxize MyTutor aplica una lógica de trazabilidad para el aprendizaje, no para el control. El objetivo es ayudar a la persona a avanzar, no evaluar cada paso con lupa.

Esta distinción es crucial en entornos corporativos donde la línea entre desarrollo profesional y evaluación del desempeño puede difuminarse. La plataforma está diseñada para que los datos de interacción se utilicen exclusivamente para mejorar la experiencia formativa, nunca como herramienta de supervisión laboral.

El concepto de «privacidad por diseño» se aplica rigurosamente en cada fase del desarrollo de Foxize MyTutor. Esto significa que la protección de datos no es una característica añadida posteriormente, sino un principio fundamental que guía todo el proceso de diseño e implementación, como recomienda Harvard Business Review.

IA responsable en la práctica

Implementamos un enfoque llamado «IA centrada en el aprendizaje», que limita el uso de datos a contextos pedagógicos, excluye decisiones automatizadas sensibles y garantiza que siempre exista supervisión humana. Además, trabajamos con arquitecturas cerradas y seguras (como Bedrock de Amazon Europa) para asegurar que ningún dato salga del entorno controlado.

Según AWS Bedrock, esta plataforma ofrece un robusto conjunto de características de seguridad que aprovechamos en Foxize MyTutor. El servicio cifra el contenido tanto en tránsito como en reposo, permitiéndonos crear, administrar y controlar nuestras propias claves de cifrado mediante AWS Key Management Service. Esto garantiza que los datos de nuestros usuarios permanezcan protegidos en todo momento.

Una ventaja crucial de AWS Bedrock para nuestra implementación ética es que, cuando ajustamos un modelo fundacional para las necesidades específicas de formación, se utiliza una copia privada del modelo. Esto significa que los datos de nuestros clientes no se comparten con proveedores externos ni se utilizan para mejorar los modelos base, manteniendo así la confidencialidad absoluta de la información.

La confianza no se impone, se construye. Por eso, ética y privacidad no son barreras para la IA, sino condiciones necesarias para su éxito en formación corporativa.

El dilema de los sesgos algorítmicos en la formación

Un desafío significativo en la implementación de sistemas de IA en entornos educativos es la mitigación de sesgos. Los algoritmos pueden perpetuar o amplificar prejuicios existentes si no son cuidadosamente diseñados y monitoreados. En Foxize MyTutor, implementamos procesos de auditoría algorítmica regulares para identificar y corregir posibles sesgos en las recomendaciones de contenido.

Según la investigación de la Fundación AI Now, «Discriminating Systems: Gender, Race and Power in AI», los sesgos algorítmicos pueden manifestarse de formas sutiles en entornos educativos, desde la recomendación desproporcionada de ciertos tipos de contenido hasta la interpretación sesgada del progreso del estudiante. Para contrarrestar esto, nuestro equipo de desarrollo trabaja con conjuntos de datos diversos y representativos, además de incorporar perspectivas multidisciplinarias en el diseño de la plataforma.

Empoderamiento del usuario a través de la transparencia

La verdadera ética en IA educativa comienza con el empoderamiento del usuario. En Foxize MyTutor, cada participante tiene acceso a información clara sobre:

- Qué datos se recopilan durante su experiencia de aprendizaje

- Cómo se utilizan estos datos para personalizar su formación

- Quién tiene acceso a su información y bajo qué circunstancias

- Cómo puede ejercer sus derechos de acceso, rectificación o eliminación

Esta transparencia no solo cumple con requisitos legales, sino que construye una relación de confianza entre la plataforma y sus usuarios. Como señala el Observatorio de Ética en IA de la UNESCO, la transparencia es el primer paso hacia una IA verdaderamente ética y centrada en el ser humano.

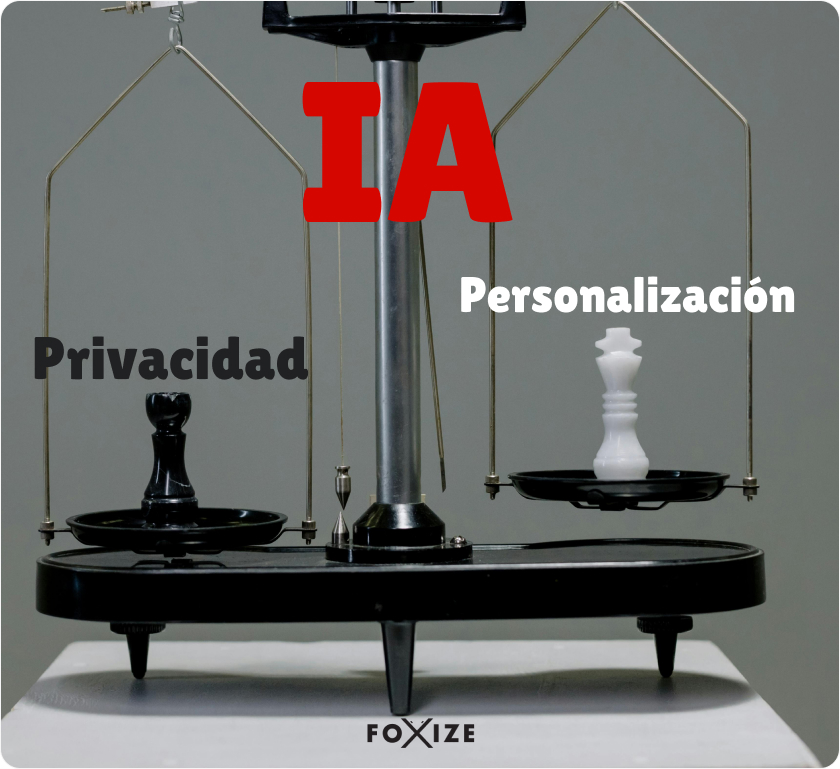

Equilibrio entre personalización y privacidad

Uno de los mayores retos en la implementación de sistemas de IA generativa en formación es encontrar el equilibrio óptimo entre personalización y privacidad. Cuantos más datos se utilizan, más precisa puede ser la personalización, pero también aumentan los riesgos para la privacidad.

Foxize MyTutor aborda este dilema mediante técnicas de minimización de datos y anonimización. Solo recopilamos la información estrictamente necesaria para ofrecer una experiencia formativa personalizada, y siempre que es posible, trabajamos con datos agregados o anonimizados.

Además, implementamos el principio de «olvido programado», eliminando datos históricos que ya no son relevantes para la experiencia de aprendizaje actual del usuario. Esta práctica reduce los riesgos de privacidad sin comprometer significativamente la calidad de la personalización, siguiendo las recomendaciones de MIT Technology Review – «The AI Ethics Gap: How Education Can Help».

Infraestructura segura y control de acceso

Nuestra implementación de Foxize MyTutor se beneficia del modelo de responsabilidad compartida de AWS, donde AWS es responsable de la «seguridad de la nube» mientras que nosotros asumimos la responsabilidad de la «seguridad en la nube».

Según AWS Bedrock, implementamos políticas basadas en identidad que proporcionan un control granular sobre qué acciones pueden realizar los usuarios, qué roles pueden desempeñar y en qué recursos, bajo qué condiciones. Esto nos permite aplicar el principio de mínimo privilegio y segmentar el acceso según sea necesario, reforzando nuestra arquitectura de seguridad.

Aprovechamos las capacidades de AWS PrivateLink para establecer una conectividad privada desde nuestra Amazon Virtual Private Cloud (VPC) a Amazon Bedrock, sin exponer el tráfico a Internet. Esto proporciona una capa adicional de seguridad para las comunicaciones entre nuestros recursos y el servicio, como detalla la documentación oficial de AWS Bedrock.

Para el monitoreo y auditoría, utilizamos las capacidades integradas de AWS Bedrock con Amazon CloudWatch para hacer seguimiento de las métricas de uso y AWS CloudTrail para supervisar la actividad de la API. Esto nos permite mantener un registro completo de todas las interacciones con el sistema, fundamental para nuestros procesos de gobernanza y cumplimiento normativo.

Gobernanza de IA y supervisión humana

La implementación ética de la IA requiere estructuras de gobernanza sólidas. En Foxize, hemos establecido un comité de ética de IA que supervisa todas las decisiones relacionadas con el uso de tecnologías de IA en nuestras plataformas formativas.

Este comité, compuesto por expertos en tecnología, educación, ética y privacidad, evalúa regularmente el impacto de nuestras soluciones de IA y propone mejoras cuando es necesario. La supervisión humana es un componente no negociable de nuestro enfoque: ninguna decisión importante sobre el aprendizaje de un usuario se toma exclusivamente por algoritmos, alineándonos con los principios del Instituto de Ética en IA de Oxford.

Nuestro enfoque de gobernanza se beneficia del cumplimiento normativo de AWS Bedrock, que como indica su documentación de seguridad, cumple con estándares comunes como ISO, SOC, CSA STAR nivel 2, y los requisitos de HIPAA. Esto nos permite ofrecer un servicio que no solo es innovador, sino que también respeta los más altos estándares de seguridad y privacidad.

Conclusión: Construyendo el futuro de la formación ética con IA

La IA generativa tiene el potencial de transformar radicalmente la formación corporativa, haciéndola más personalizada, efectiva y accesible. Sin embargo, este potencial solo se realizará plenamente si se implementa con un compromiso inquebrantable con la ética y la privacidad.

En Foxize, creemos que la tecnología debe servir a las personas, no al revés. Nuestra visión de MyTutor es crear una herramienta que potencie el desarrollo profesional respetando siempre la dignidad, autonomía y privacidad de cada participante.

La formación del futuro será personalizada, adaptativa e impulsada por IA, pero también debe ser ética, transparente y centrada en el ser humano. Este es nuestro compromiso y la guía que orienta cada aspecto del desarrollo e implementación de Foxize MyTutor, siguiendo las directrices de la Comisión Europea.

Al final, la verdadera innovación no está solo en lo que la tecnología puede hacer, sino en cómo la implementamos para mejorar la vida de las personas mientras protegemos sus derechos fundamentales. En Foxize, estamos comprometidos con liderar este camino hacia una IA formativa que sea tan ética como efectiva.